私たちは 2 月に Gemma を発表しました。Gemma は最先端の軽量オープンモデル ファミリーで、Gemini モデルと同じ研究技術で構築されています。すばらしいファインチューニングが行われたバリアント、Kaggle ノートブック、ツールやサービスへの組み込み、MongoDB のようなデータベースを使った RAG のレシピなど、コミュニティからは大きな反応がありました。

本日は、Gemma ファミリーへの最初のラウンドの機能追加についてお知らせすることで、ML デベロッパーの責任あるイノベーションの可能性を広げます。CodeGemma は、コード補完や生成タスク、そして指示実行用です。RecurrentGemma は、研究実験の効率を最適化したアーキテクチャです。また、コミュニティやパートナーからの貴重なフィードバックに基づく改善を行えるように、Gemma と利用規約をアップデートしたことについてもお知らせします。

Gemma モデルを基盤とした CodeGemma は、強力でありながら軽量なコーディング機能をコミュニティにもたらします。CodeGemma モデルは、コード補完とコード生成タスクを専門とする事前トレーニング済み 7B バリアント、コードチャットと指示実行用の命令チューニング済み 7B バリアント、そしてローカル コンピュータで実行できる高速コード補完用の事前トレーニング済み 2B バリアントとして利用できます。CodeGemma モデルにはいくつかの利点があります。

CodeGemma の詳細については、レポートまたはこちらのクイックスタート ガイドを参照。

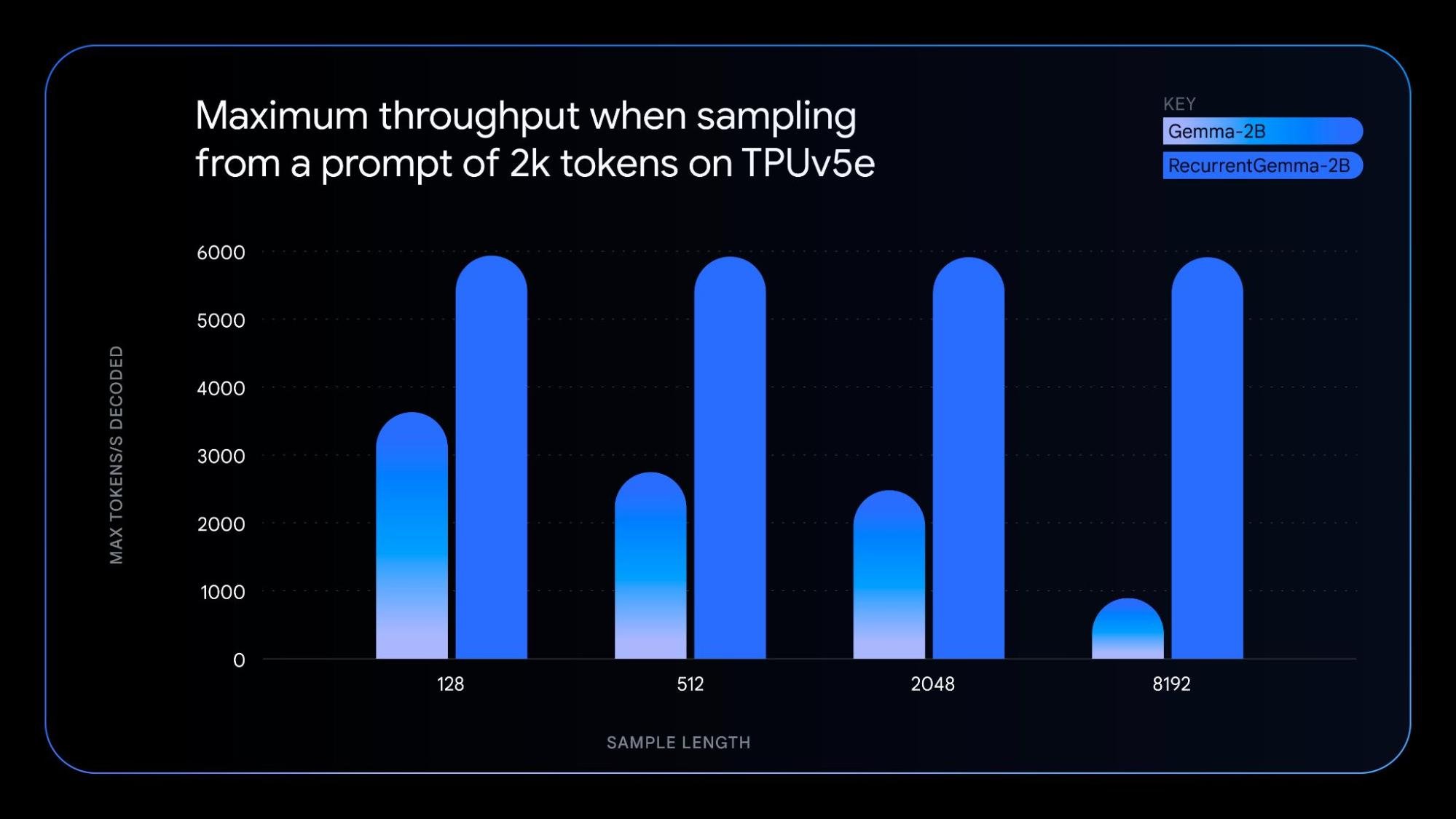

RecurrentGemma は、回帰型ニューラル ネットワークとローカル アテンションを活用してメモリ効率を改善しており、技術的に特徴あるモデルです。RecurrentGemma のユニークなアーキテクチャは、Gemma 2B モデルと同様のベンチマーク スコア性能を達成しながら、いくつかの利点をもたらします。

基礎となるテクノロジーを理解したい方は、私たちの論文をご覧ください。実際に確認してみたい方は、モデルをファインチューニングする方法を示したノートブックをお試しください。

新しいモデルのバリアントは、オリジナルの Gemma モデルと同じ原則に基づいており、以下のような特徴があります。

- CodeGemma と RecurrentGemma の両方: JAX で構築され、JAX、PyTorch、Hugging Face Transformers、Gemma.cpp と互換性があります。ノートパソコン、デスクトップ、NVIDIA GPU、Google Cloud TPU などのさまざまなハードウェアで動作し、ローカルで実験することも、コスト効率よくデプロイすることもできます。

- CodeGemma: 加えて Keras、NVIDIA NeMo、TensorRT-LLM、Optimum-NVIDIA、MediaPipe と互換性があり、Vertex AI で利用できます。

- RecurrentGemma: 今後数週間以内に、前述のプロダクトに対応する予定です。

新しいモデルのバリアントのほかに、パフォーマンスの向上を含む Gemma 1.1 をリリースします。さらに、デベロッパーからのフィードバックに耳を傾け、バグを修正し、利用規約を更新して、柔軟性を高めました。

ここで説明した最初の Gemma モデルのバリアントは、本日より、Kaggle、Hugging Face、Vertex AI Model Garden をはじめとする世界中のさまざまな場所で公開されます。次のようにして使ってみることができます。

CodeGemma と RecurrentGemma モデルをお試しいただき、Kaggle でフィードバックをお寄せください。AI を活用したコンテンツ作成とコンテンツ理解の未来を一緒に築きましょう。